"Você não precisa de um PhD do MIT para fazer a diferença na luta pela justiça algorítmica.

Tudo que você precisa é de uma mente curiosa e um coração humano"

Joy Buolamwini, PhD, no livro "Unmasking AI"

Em 2023, a mídia global em língua inglesa citou cinco personalidades masculinas ao falar de inteligência artificial (IA) – Elon Musk, Sam Altman, Geoffrey Hinton, Jensen Huang e Greg Brockman – com oito vezes mais frequência que todas as 42 mulheres especialistas em IA na lista das 100 pessoas mais influentes no campo de IA feita pela revista Time, que inclui nomes como Grimes, Margrethe Vestager, Timnit Gebru, Margaret Mitchell, Emily Bender e Joy Buolamwini.

Esse viés de gênero, revelado pela análise de 5 milhões de artigos que fazem referência à IA presentes na base de dados de notícias da GDELT feita pela empresa AKAS em 2023, passou despercebido pelo jornalismo. Conter o viés de gênero nas discussões sobre IA é um caminho importante para garantir que o noticiário reflita a diversidade do nosso mundo e que seja relevante para uma audiência o mais ampla possível.

Eu conversei com vários especialistas sobre vieses na IA generativa, incluindo o viés de gênero, e o papel do jornalismo no combate aos mesmos.

Os três vieses artificiais criados pela IA generativa

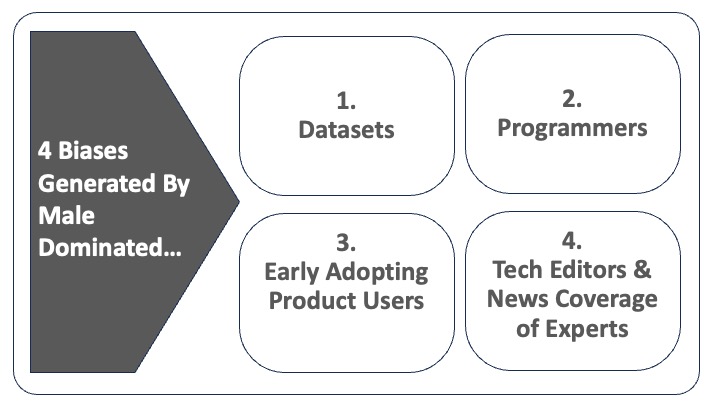

A existência de vieses embutidos na IA generativa – que inclui ChatGPT, Bard (do Google) e geradores de imagem como Midjourney – silencia e distorce, isso quando não apaga completamente, as vozes de alguns grupos sub-representados. Isso acontece porque a IA generativa amplifica vieses sociais por meio dos conjuntos de dados usados em algoritmos para gerar texto, imagem e vídeo, utilizando um pequeno grupo não representativo como o padrão para toda a população global.

A perspectiva que os programadores têm do mundo também orienta os algoritmos desenvolvidos por eles, adicionando ainda mais vieses ao conteúdo gerado. Por exemplo, a tecnologia de reconhecimento facial, usada pela polícia, é desproporcionalmente baseada em dados de rostos brancos (80%) e masculinos (75%). Embora a precisão na identificação de rostos de homens brancos seja de 99 a 100%, ela cai drasticamente para 65% com mulheres negras. De modo semelhante, textos de notícias assistidos por IA generativa são baseados fortemente em um conjunto histórico de artigos nos quais a proporção dos homens entre as vozes de colaboradores e protagonistas é muitas vezes mais alta que a de mulheres.

Algoritmos criados com esses vieses se tornam o que Joy Buolamwini chama em seu novo livro, "Unmasking AI" (Desmascarando a IA, em tradução livre), de "o olhar codificado" (por exemplo, prioridades, preferências e até mesmo os preconceitos de quem escreve os códigos refletidos nos produtos que eles moldaram). Os grupos sub-representados se tornam os "excluídos do código" (por exemplo, pessoas ou grupos que são prejudicados pelos sistemas de algoritmos). O "olhar codificado" aprofunda os vieses que existem nos conjuntos de dados.

Uma terceira camada de viés vem dos usuários do produto, por exemplo os primeiros usuários de geradores de texto como o ChatGPT ou geradores de imagem como Midjourney, DALL-E e Stable Diffusion. Nas palavras de Octavia Sheepshanks, jornalista e pesquisadora de IA, "o que na maioria das vezes não se fala é o fato de que as pessoas que usam as imagens também moldaram os modelos de geradores de imagens."

Esses primeiros usuários moldam ainda mais o conteúdo gerado por IA pela forma com que interagem com os produtos, com seus próprios vieses alimentando os algoritmos de autoaprendizagem.

Perspectivas dominadas por homens brancos do Norte Global

O que esses conjuntos de dados, programadores e usuários têm em comum? Eles são imensamente mais propensos a representar suas perspectivas, valores e gostos dos homens brancos falantes de inglês das culturas do Hemisfério Norte.

Em uma análise de conteúdo do ChatGPT feita em agosto de 2023 explorando como gênero e raça influenciam a representação de CEOs no conteúdo da ferramenta, Kalev Leetaru, fundador do projeto GDELT, concluiu que "o resultado final levanta questões existenciais sobre viés de gênero e de raça" sobre os grandes modelos de linguagem (LLMs na sigla em inglês).

Por exemplo, enquanto o ChatGPT descreveu homens brancos bem-sucedidos que são CEOs com base em suas habilidades, CEOs bem-sucedidas mulheres ou de minorias raciais foram descritas com base em sua identidade e capacidade de combater adversidade, em vez de seu conjunto de habilidades baseadas em competências.

Visões libertárias que valorizam a defesa da liberdade de expressão e proteção da inovação online em vez do intervencionismo permeiam as Big Techs e escolas de engenharia. Elas representam uma barreira para lidar com o viés na IA.

Hany Farid, professor de ciência da computação na Universidade da Califórnia em Berkeley, teme que essas visões, na melhor das hipóteses, mascarem a ignorância, ou uma apatia e falta de cuidado subjacentes por parte do setor de IA no pior dos casos. Ele argumenta que elas representam "uma forma perigosa de ver o mundo, principalmente quando você foca nos danos que foram feitos contra mulheres, crianças e grupos, sociedades e democracias sub-representadas."

O jornalismo adiciona um quarto impedimento para tratar o problema do viés na IA generativa

Há um perigo de que os jornalistas também estejam ajudando a deixar mulheres e grupos sub-representados de fora do futuro da IA. Atualmente, somente um pequeno número de editores de tecnologia nos Estados Unidos (18%) e no Reino Unido (23%) são mulheres. Além disso, no noticiário de tecnologia, as mulheres são apresentadas como especialistas, colaboradoras ou protagonistas com quatro vezes menos frequência que os homens, de acordo com a análise GDELT.

Quando sobrepomos a dimensão de raça ao gênero, o problema se agrava de várias formas. Primeiro, mulheres de grupos raciais minoritários são significativamente mais propensas do que homens ou mulheres brancas a serem excluídas de decisões editoriais e de participarem como colaboradoras de matérias. Segundo, quando são entrevistadas, mulheres de grupos raciais minoritários são bem mais propensas a receberem perguntas baseadas em sua identidade em vez de seu conhecimento.

Agnes Stenbom, chefe do IN/LAB, na cidade de Schibsted, na Suécia, alerta que os veículos jornalísticos precisam ter consciência do seu uso de linguagem sexista – por exemplo, evitar presumir que médicos são homens e enfermeiras são mulheres – já que isso pode "cimentar ainda mais" vieses de gênero.

Lars Damgaard Nielsen, CEO e cofundador da MediaCatch, alerta que mulheres de minorias raciais são especialmente sub-representadas no noticiário na Dinamarca. Isso se reflete na forma como as pessoas de grupos raciais minoritários são representados no noticiário, de acordo com uma análise do ano passado feita usando a ferramenta de IA DiversityCatch, da MediaCatch, que mostrou que "pessoas não-Ocidentais frequentemente não estão nas notícias por causa de sua expertise profissional, mas por causa de sua identidade".

O jornalismo precisa agir como um vigilante da IA generativa para diminuir os vieses existentes

A forma mais eficaz de diminuir os vieses ligados à homogeneidade é criar conjuntos de dados mais inclusivos, conforme argumenta Buolamwini em seu livro. Porém, reguladores e jornalistas enfrentam um desafio significativo contra o qual devem lutar: eles não sabem quais dados exatamente são usados pela IA, devido à falta de transparência do setor.

"A transparência está cada vez mais limitada. Com a entrada do lucro na equação, as empresas estão se tornando mais privadas com os seus modelos e menos propensas a compartilhar", argumenta Jessica Kuntz, diretora de políticas do Pitt Cyber. Essa falta de transparência evita auditorias dos algoritmos, dificultando que os jornalistas construam barreiras para se proteger dos vieses.

Se for permitido que o setor de IA generativa se desenvolva sem ser contestado, conforme estipulam atualmente as Big Techs, o mundo, em um futuro repleto de IA, vai cada vez mais carecer de diversidade de perspectivas, tais como as de mulheres, minorias étnicas, pessoas do Sul Global e outras culturas.

Em um próximo artigo, vou explorar dois conjuntos de soluções para que as redações diminuam o domínio de vozes masculinas na cobertura jornalística da IA generativa.

Foto por Emiliano Vittoriosi via Unsplash.