"No necesitas un doctorado del MIT para marcar la diferencia en la lucha por la justicia algorítmica. Todo lo que necesitas es una mente curiosa y un corazón humano."

Joy Buolamwini, PhD, “Unmasking AI”

En 2023, medios internacionales en lengua inglesa citaron a cinco figuras masculinas prominentes en el campo de la inteligencia artificial (IA) —Elon Musk, Sam Altman, Geoffrey Hinton, Jensen Huang y Greg Brockman— ocho veces más frecuentemente que a las 42 mujeres expertas en IA destacadas en la lista de las 100 personas más influyentes en IA de la revista Time. Entre estas mujeres se encuentran nombres como Grimes, Margrethe Vestager, Timnit Gebru, Margaret Mitchell, Emily Bender y Joy Buolamwini.

Este sesgo de género, revelado mediante el análisis de AKAS de 5 millones de noticias en línea en 2023 relacionadas con la IA en la base de datos global de noticias en línea GDELT, ha pasado inadvertido para el periodismo. Mitigar este sesgo en los debates sobre la IA es fundamental para asegurar que las noticias reflejen la diversidad de nuestro mundo y sean relevantes para un público más amplio.

Hablé con varios expertos sobre los prejuicios de la IA generativa, incluidos los de género, y el papel del periodismo para superarlos.

Los tres sesgos creados por la IA generativa

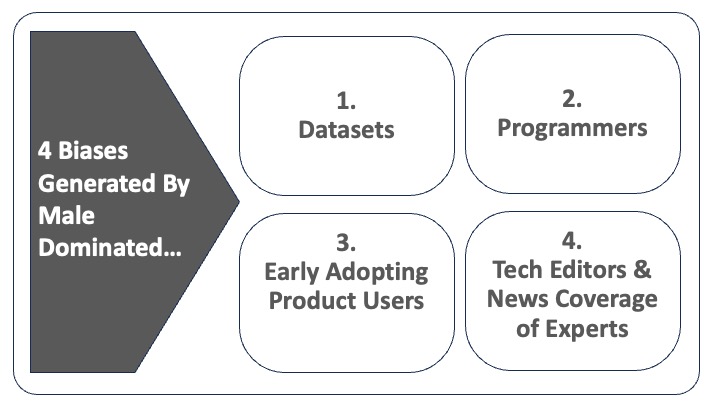

La existencia de sesgos en la IA generativa (GenAI) —que incluye ChatGPT, Bard de Google y generadores de imágenes como Midjourney— distorsiona y silencia, cuando no borra directamente, las voces de ciertos grupos infrarrepresentados. Esto sucede porque la IA generativa amplifica prejuicios sociales a través de los conjuntos de datos que utiliza en sus algoritmos para generar textos, imágenes y vídeos. Estos conjuntos de datos a menudo están basados en un pequeño grupo no representativo de la población, pero se utilizan como referencia para toda la población mundial.

La propia visión del mundo de los programadores también influye en los algoritmos que desarrollan, lo que suma un sesgo adicional a los contenidos generados. Por ejemplo, la tecnología de reconocimiento facial, utilizada por la policía, se basa desproporcionadamente en datos de rostros blancos (80%) y masculinos (75%). Mientras que la precisión es del 99-100% en la detección de rostros masculinos blancos, cae bruscamente al 65% en el caso de las mujeres negras. Del mismo modo, los artículos noticiosos asistidos por GenAI se basan en gran medida en un conjunto histórico de artículos en los que la proporción de hombres como colaboradores/protagonistas es varias veces superior a la de mujeres.

Los algoritmos creados con estos sesgos se convierten en lo que Joy Buolamwini llama en su nuevo libro, Unmasking AI, "la mirada codificada" (es decir, las prioridades, preferencias e incluso los prejuicios de los programadores reflejados en los productos a los que han dado forma). Los grupos infrarrepresentados se convierten en "los excodificados", es decir, individuos o comunidades perjudicados por esos sistemas algorítmicos. Así, la "mirada codificada" profundiza los sesgos existentes en los conjuntos de datos.

Una tercera capa de sesgos procede de los usuarios de los productos, por ejemplo los primeros en adoptar los generadores de texto GenAI como ChatGPT o los generadores de imágenes como Midjourney, DALL-E y Stable Diffusion. En palabras de Octavia Sheepshanks periodista e investigadora de IA: "Lo que no se suele mencionar es el hecho de que son las personas que utilizan las imágenes las que también han dado forma a los modelos de los generadores de imágenes".

Estos primeros usuarios del producto moldean aún más el contenido generado por la IA a través de la forma en que interactúan con los productos, y sus propios prejuicios se retroalimentan a los algoritmos de aprendizaje automático.

Hany Farid, profesor de informática en la Universidad de California, Berkeley, teme que estas perspectivas enmascaren, en el mejor de los casos, una ignorancia ética, o en el peor, una apatía subyacente y falta de preocupación por parte del sector de la inteligencia artificial. Él sostiene que representan "una forma peligrosa de ver el mundo, especialmente cuando se enfocan en los daños causados a mujeres, niños y grupos subrepresentados, así como a sociedades y democracias".

El periodismo suma un cuarto impedimento

Existe el peligro de que los periodistas también contribuyan a la exclusión de las mujeres y otros grupos infrarrepresentados del futuro de la IA. En la actualidad, solo una pequeña minoría de los redactores de noticias tecnológicas en Estados Unidos (18%) y Reino Unido (23%) son mujeres. Además, de acuerdo con nuestro análisis GDELT, las mujeres aparecen en las noticias sobre IA como expertas, colaboradoras o protagonistas cuatro veces menos que los hombres.

Si sumamos la dimensión racial al género, el problema se agrava. En primer lugar, las mujeres de color tienen una mayor probabilidad que los hombres o mujeres blancos de ser excluidas de la toma de decisiones editoriales y de participar como colaboradoras en las noticias. En segundo lugar, cuando se les entrevista, las mujeres de color tienen más probabilidades de ser cuestionadas sobre su identidad en lugar de su experiencia.

Agnes Stenbom, directora de IN/LAB en Schibsted (Suecia), advierte que los medios deben ser conscientes del uso que hacen del lenguaje sexista —por ejemplo, no dar por sentado que los médicos son hombres y las enfermeras mujeres—, ya que esto puede "cimentar aún más" los prejuicios sexistas.

Lars Damgaard Nielsen, CEO y cofundador de la organización danesa MediaCatch, señala que las mujeres de color están especialmente infrarrepresentadas en las noticias en Dinamarca. Esto se refleja en cómo se las retrata en las coberturas, de acuerdo a un análisis realizado el año pasado con la herramienta DiversityCatch, basada en IA, que demostró que "las personas no occidentales a menudo no están ahí por su experiencia profesional, sino por su identidad".

¿La tarea del periodismo? Mitigar estos sesgos

La forma más eficaz de mitigar los sesgos relacionados con la homogeneidad es crear conjuntos de datos más inclusivos, como sostiene Buolamwini en su libro. Sin embargo, los reguladores y los periodistas se enfrentan a un problema importante: no conocen los datos exactos de los que se nutre la IA debido a la falta de transparencia de la industria de la IA.

"La transparencia es cada vez más limitada. Como el beneficio económico ha entrado en la ecuación, las empresas se han vuelto más propietarias de sus modelos y están menos dispuestas a compartirlos", argumenta Jessica Kuntz, directora de Pitt Cyber. Esta falta de transparencia impide las auditorías algorítmicas, lo que dificulta que los periodistas construyan barreras para protegerse de los sesgos.

Si se permite que el espacio de la GenAI siga desarrollándose sin oposición alguna, como la Big Tech estipula actualmente, el mundo de la IA del futuro se encontrará cada vez más desprovisto de una diversidad de perspectivas, como las de las mujeres, las minorías étnicas, el público del Sur global y otras culturas.

En un artículo posterior, exploraré dos soluciones para las salas de redacción que pueden colaborar a mitigar el predominio de las voces masculinas en la cobertura de noticias de la IA generativa.

Foto de Emiliano Vittoriosi en Unsplash.