一些由演算法为我们的生活所做的决策是良性的,比如那些让人难以抗拒的在 Netflix 上的“观看建议”。但是当企业和政府在我们不知情的情况下使用人工智能和机器学习来做出影响我们生活的决策时,情况就变得复杂了。更糟糕的是,我们无法就这些决策做出抗议。

这些代码被那些使用它们的人认为是几乎颠扑不破的。银行和其他借贷机构决定你的信用等级,公司和招聘者考虑是否聘请你,而你的保险公司依据人工智能所做的决定判断你的保险情况。

并且当考虑演算法在决策制定过程中的作用时,我们不仅仅需要考虑演算法是完整的决策过程最终决定者的情况,也要考虑演算法即使最终决策是由人做出,但是演算法在过程中起到关键作用的情况。

但是这些软件中的许多都有根深蒂固的偏见,“演算法正义联盟” 的创始人 Joy Buolamwini 称之为 “编码凝视”。这是能够使得不公延续,并且提升宿命感的偏见 — 一种我们除了在人工智能无处不在的世界做的事情以外无法做其他任感受。

“很明显演算法被不断增加使用以支持决策制定,尽管为实践中的效率提升带来了机会,也带来了关乎不公和歧视性结果的风险。” 性别、种族、群落以及地域都可能导致整个社群得不到益处并使得他们处于劣势之中。

简单来讲,演算法可以是种族主义的。正如美国众议员 Alexandria Ocasio-Cortez 所说,演算法 “永远会有这些被传输出的种族不平等,因为演算法依然是人做出的,并依然与基本的人类判断相连。它们只是自动的而已。并且自动的判断——如果你不去纠正偏见,那么你就只是在自动化这些偏见。”

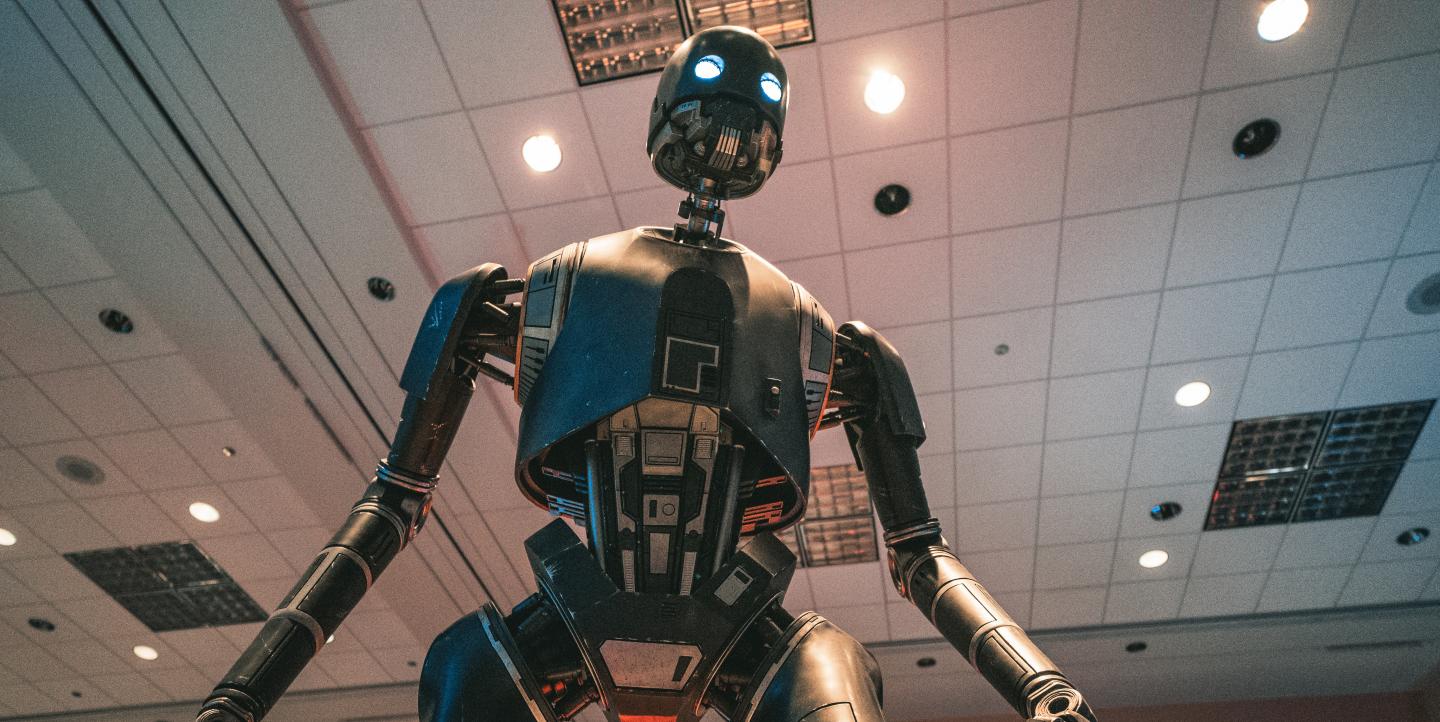

这就像是邪恶的人工智能每秒都在变得更强大扼住喉咙的时刻。并且演算法是以一种比种族隔离的吉姆克劳法更加快速、能更频繁地影响更多人的方式。

这种算法偏见,正如 Joy Buolamwini 在浏览一份香港初创企业的无法探查人脸,但可以 “如同从互联网下载文件一样快速移动” 的 “社交机器人” 时发现的。

这家初创企业使用她在乔治亚理工做本科作业时相同的基本人脸识别软件,她发现并不在她的脸部起作用 — 并且她只能让她的(白人)室友帮忙。当时,在地球另一边,她发现 “另一些可以纠正”。在到了香港之后,她意识到有一些人将会成为她。

(要了解演算法偏见的摘要,查看 Karen Hao 的文章)。

那么我们可以针对演算法偏见做些什么呢?如果你是一名软件开发者或者数据科学家,IBM 研发有一个可以帮助你在你的数据模型中检验偏见的开源工具箱。

但是并不只有技术人员能够针对演算法偏见做些事情。你可以通过探索你在技术服务领域的选择开始扩展数码空间。比如,使用诸如 DuckDuckGo 的搜索引擎,因为不同于谷歌这样饥渴的数据吸血鬼,它并不会存储你的个人信息并且使用它来做广告。

你可以呼吁或者游说你的政府来采纳一个加强演算法可靠性和透明度的政策,使之 “演算法素养” 能够通过课程、标准化通知 (沟通演算法决策过程中的类型和程度) 成为了一个要求。

最终,我们需要询问自己和技术公司更多。仅仅使用批判性思维还不够——我们也需要关于我们如何构建和使用这些技术的公民思维。