¿Liberales y conservadores reaccionan de manera diferente a la desinformación? ¿Cuántas conversaciones sobre política suceden online? ¿La desinformación proporcionada por un bot tiene efectos diferentes que la proporcionada por una persona real? ¿Cuáles son las consecuencias reales del hecho de estar online?

Un informe publicado esta semana por la fundación filantrópica Hewlett , "Redes sociales, polarización política y desinformación política: una revisión de la literatura científica", tiene como objetivo discernir entre lo que sabemos y lo que ignoramos sobre la relación entre estos temas. El informe es especialmente útil como una especie de catálogo de las preguntas que aún debemos responder y señala en qué lugares la investigación existente entra en conflicto.

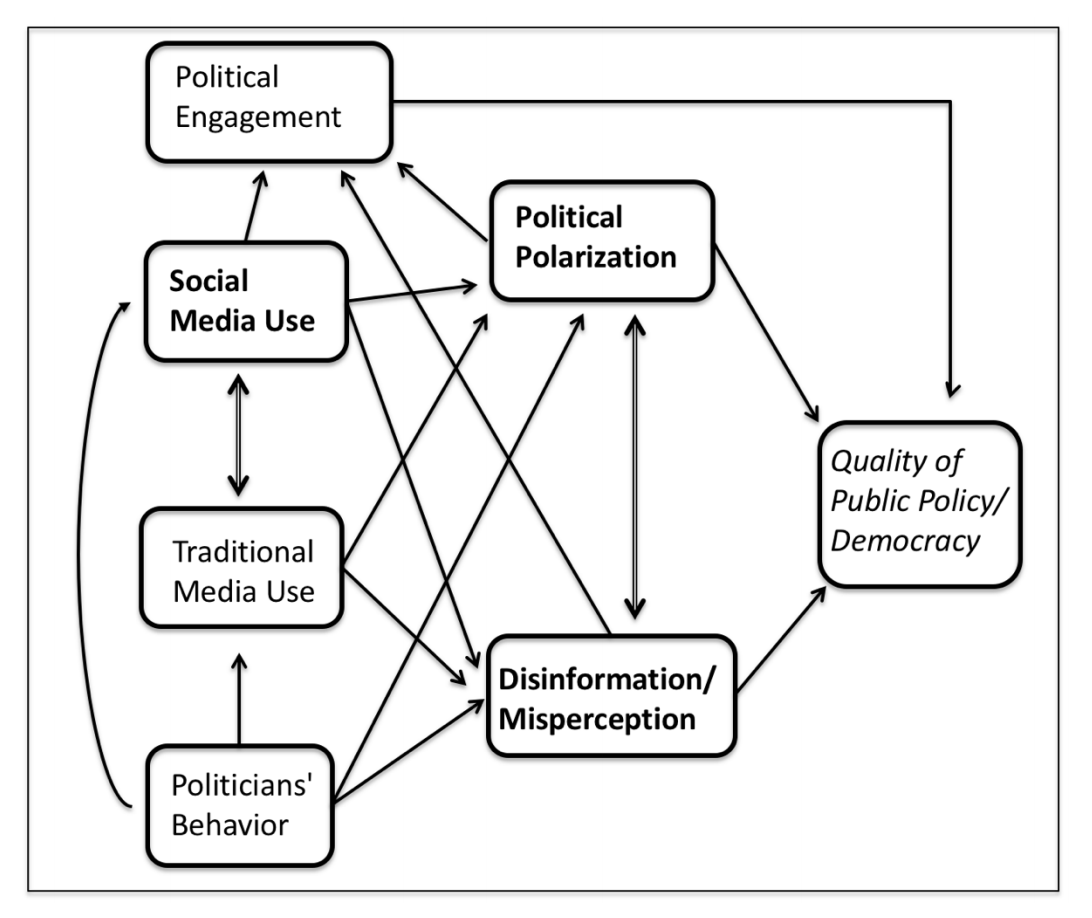

El informe, que incluye investigaciones escritas por varios académicos especializados en diferentes áreas (el autor principal Joshua A. Tucker y Andrew Guess, Pablo Barberá, Cristian Vaccari, Alexandra Siegel, Sergey Sanovich, Denis Stukal y Brendan Nyhan), comienza con un cuadro de todas las "piezas en movimiento". Los autores deliberadamente decidieron no vincular el uso de las redes sociales con la calidad de la democracia; las redes sociales no son intrínsecamente democráticas o antidemocráticas, escriben, "sino simplemente un escenario en el que los actores políticos -que pueden o no ser democráticos- compiten por el poder y la influencia". (En 2010, Journal of Democracy presentó un artículo sobre las redes sociales titulado "Tecnología de liberación". En 2017, la misma revista decía: "¿Puede la democracia sobrevivir en Internet?").

Estas son algunas de las cosas que no sabemos, que a veces se superponen con otras que tampoco.

¿Qué es una "conversación política online"? ¿Qué es una "cámara de resonancia"?

Olvídate de las "noticias falsas" y la "desinformación" (aunque también necesitamos acordar una definición para ellas): ni siquiera hay consenso, entre los académicos, sobre lo que es en realidad una "conversación política online" o una "cámara de resonancia". Muchas investigaciones han tratado de enfocarse en la cantidad de desacuerdos a los que las personas están expuestas online, pero no tenemos una definición estándar sobre qué tipo de conversación cuenta como "política", qué cuenta como desacuerdo, o incluso qué cuenta como una conversación en primer lugar (por ejemplo, ¿qué pasa si uno de los lados es un bot?). Y luego está la cámara de resonancia: "Hasta la fecha, no sólo no hay consenso sobre qué nivel de exposición selectiva constituye una 'cámara de resonancia'; ni siquiera hay consenso sobre qué método se debe usar para medir esta exposición selectiva".

¿Los grupos online están expuestos a diferentes niveles de desinformación? ¿Sus reacciones son diferentes?

¿Liberales y los conservadores ven diferentes cantidades de desinformación online, por ejemplo? ¿Qué pasa con las personas que están mucho tiempo en redes sociales? Necesitamos saber más sobre cómo las diferentes personas reaccionan a las mismas cosas. Los autores sugieren que podríamos comenzar estudiando "si los extremistas tienden a reaccionar de manera diferente a la gente más moderada", o si los conservadores reaccionan de manera diferente a los liberales. "Si la desinformación o la polarización política afectan a conservadores y liberales de manera diferente, entonces este tipo de investigación parecería ser particularmente importante para seguir avanzando".

¿Cómo reaccionan los individuos cuando están expuestos a la desinformación?

Algunos investigadores han encontrado un efecto de "retroceso o boomerang", en el que las personas se plantan con mayor fuerza sobre su postura original cuando se encuentran expuestos a información que la contradice. Pero si esto está sucediendo (y algunos investigadores creen que no), no está claro cuánto de eso es simplemente "arenga partidaria" y cuánto creencia legítima.

Varios estudios sobre el "grado en que la desinformación compartida en las redes sociales tiene algún efecto sobre las creencias políticas de los ciudadanos", o de si esta aumenta o no la polarización, arrojan resultados contradictorios, en parte porque los estudios usan definiciones diferentes de lo que son la desinformación y la polarización. "A veces la diferencia entre rumor, información falsa, información engañosa e información hiperpartidista resulta confusa". Además, no se trata sólo de a quién se vota: necesitamos investigar más sobre cómo la exposición a la desinformación afecta el punto de vista de las personas sobre varios temas, su interés general en política, y su confianza en las instituciones.

Los estudios generalmente se enfocan en una plataforma, pero muchas personas usan múltiples plataformas (incluyendo medios offline)

La mayoría de las investigaciones en redes sociales se enfocan en Twitter. Sin embargo, como señaló Jonathan Albright, no es Twitter sino Facebook donde se encuentra la mayor parte de la gente, pero no tenemos mucha investigación sobre cómo el uso de Facebook afecta la política (es difícil analizar Facebook). El informe también exige un mayor análisis de los resultados de búsquedas de Google. Y también están los medios tradicionales: ¿Cómo interactúan con las redes sociales? ¿En qué medida están los "rumores políticos de redes sociales" migrando hacia los medios tradicionales? ¿Cuáles son las estrategias de las redes sociales de los medios hiperpartidarios?

¿Hasta qué punto se puede aplicar la investigación realizada en Estados Unidos al resto del mundo?

El sistema político bipartidista de Estados Unidos es atípico. Tampoco está claro aún cómo "los medios digitales pueden contribuir a la polarización y la desinformación en regímenes más inestables, híbridos y no democráticos".

El informe completo, que contiene muchas más cosas que no sabemos (¡y algunas que sí!), está aquí.

Imagen principal con licencia de CC de Pixabay, a través de TeroVesalainen.

Este artículo fue publicado originalmente en el Nieman Lab. Fue editado y vuelto a publicar en IJNet con permiso.