本文是关于应对生成式人工智能的偏见的系列文章的上篇。请点按阅读下篇。

“你不需要麻省理工学院的博士学位,也能为争取演算法正义出一分力。

你所需要的只是一颗好奇、人性的心。”

Joy Buolamwini 博士,“揭开人工智能的面纱”

2023 年,全球英文媒体引述了人工智能(AI)领域的五位男性人物——马斯克(Elon Musk)、奥尔特曼(Sam Altman)、辛顿(Geoffrey Hinton)、黄仁勋(Jensen Huang)和布罗克曼(Greg Brockman)— —的频率比《时代》杂志的全球 100 位最有影响力 AI 人士名单中聚焦的 42 名女性 AI 专家高出八倍。这些女性专家包括 Grimes、Margrethe Vestager、Timnit Gebru、Margaret Mitchell、Emily Bender 和 Joy Buolamwini 等。

AKAS 针对 2023 年 GDELT 全球线上新闻资料库中引用 AI 的 500 万篇在线新闻文章进行分析后发现,这种性别偏见尚未引起新闻界的关注。减少 AI 讨论中的性别偏见,是确保新闻如实反映世界多样性并与尽可能引起广泛受众共鸣相关的重要方法。

为此,我访问了几位专家,探讨生成式人工智能(GenAI)的偏见(包括性别偏见),以及新闻业在打破这些偏见方面的角色。

生成式人工智能造成的三种人为偏见

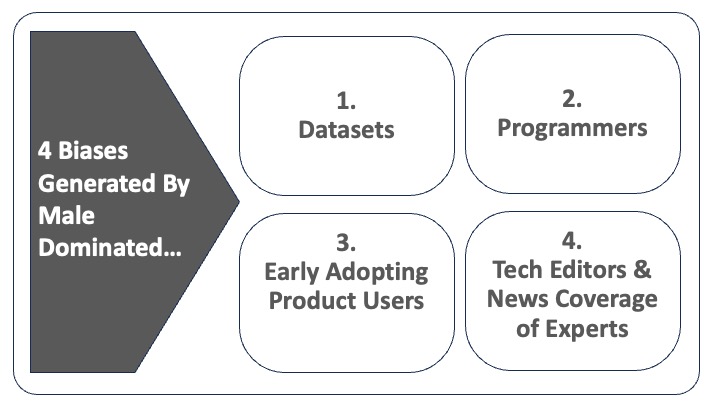

生成式人工智能(GenAI)中存在的偏见(包括 ChatGPT、Google的 Bard 和 Midjourney 等图像生成工具)能削弱、扭曲甚至消减某些代表性本已不足的社群之声音——如果不是彻底消除的话。这是因为 GenAI 透过它在演算法中使用的数据集来生成文字、图像和视频,而这些数据集本来就是以不具广泛代表性的小群体作为整个全球人口的预设值,社会偏见因而被複製及放大。

程式设计师自己的视野也会影响了他们开发的演算法,进一步增加生成内容的偏见。例如,警队常用的脸部辨识技术不成比例地基于白人(80%)和男性(75%)脸孔的数据,虽然检测白人男性面孔的准确度为 99-100%,但检测非裔女性面孔的准确率却急剧下降至 65%。同样,GenAI 辅助的新闻文章严重依赖历史文章库,而传统上男性在消息来源/主叙事者中所佔的比例是女性的数倍。

建基于这些偏见的演算法就是 Joy Buolamwini 在她的新书《Unmasking AI: My Mission to Protect What Is Human in a World of Machines》中所说的 “编码凝视”(the coded gaze,即编码者的优次选项、偏好甚至偏见在他们所塑造的产品中反映出来)。代表性不足的群体成为 “被编码者”(即受到演算法系统伤害的个人或社群)。简言之,“编码凝视” 加深了数据集中本已存在的偏见。

第三重偏见来自产品的使用者,例如 ChatGPT 等 GenAI 文本生成工具或 Midjourney、DALL-E 和 Stable Diffusion 等影像生成工具的早期用家。用记者兼 AI 研究员 Octavia Sheepshanks 的话说:“人们经常忽视的是,使用图像的人也在模塑了图像生成工具的模型。”

这些早期使用家透过与产品互动的方式,进一步模塑 AI 所生成的内容,并将自己的偏见回馈予自行学习的演算法。

全球-发达国家-白人-男性主导的观点

这些数据集、程式设计师和产品使用者有什麽共同点?他们极有可能都代表着已发展国家文化中讲英语的白人的观点、价值观和品味。

GDELT 项目创办人 Kalev Leetaru 在 2023 年 8 月针对 ChatGPT 的内容分析探讨了性别和种族如何影响 ChatGPT 内容对行政总裁的描绘,结论是其结果进一步引发关于大型语言模型(LLMs)的 “既有性别和种族偏见问题”。

例如,虽然 ChatGPT 根据技能来描述成功的白人男性行政总裁,但成功的女性和有色人种行政总裁则往往按他们的身分和对抗逆境的能力来描述,而非他们的技能。

大型科技和工程学校普遍存在自由主义者的观点,即重视捍卫言论自由和保护网络创新而不是干预主义;这些观点妨碍了解决人工智能中的偏见。

加州大学柏克莱分校电脑科学教授 Hany Farid 担心,这些观点往好了说是掩盖了道德无知,往坏了说是掩盖了人工智能产业潜在的冷漠和缺乏关怀。他认为,它们代表了 “一种看待世界的危险方式,特别是当你关注对女性、儿童以及代表性不足的社群、社会和民主国家所造成的伤害时。”

新闻业为解决 GenAI 偏见问题增添了第四个障碍

记者也可能有份将女性和其他代表性不足的社群排拒于人工智能的未来之外。目前,美国(18%)和英国(23%)的科技新闻编辑中只有一小部分是女性。此外,根据我们的 GDELT 分析,在人工智能相关的新闻报道中,女性作为被引述的专家、消息来源或主要报道对象的频率较男性低四倍。

当我们将种族维度叠加到性别上时,问题会在几个方面变得更加複杂。首先,有色人种女性比男性或白人女性更有可能被排拒于编辑决策之外,也更难成为故事的消息来源或引述对象;其次,在接受访谈时,有色人种女性更有可能被问到针对她们的身分而不非专业知识的问题。

位于瑞典希布斯特德(Schibsted)的 IN/LAB 负责人 Agnes Stenbom 提醒,新闻机构必须注意性别语言的使用,例如不要假设医生是男性,护士是女性,因为这会 “进一步巩固” 性别偏见。

丹麦 MediaCatch 行政总裁兼联合创始人 Lars Damgaard Nielsen 则提醒,有色人种女性在丹麦新闻中的代表性尤其不足。去年,一个利用 MediaCatch 的人工智能驱动工具 DiversityCatch 进行的分析报告显示,这种代表性不足反映在新闻中对有色人种的描述上:“非西方人出现在新闻中往往不是因为他们的专业知识,而是因为他们的身分。”

新闻业必须充当 GenAI 技术的监督者,以减少既有偏见

正如 Buolamwini 在她的书中所指,减轻同质性相关偏差的最有效方法,就是创建更多元共融的数据集。然而,监管机构和记者面临着一个他们应该努力应对的重大挑战——由于人工智能产业缺乏透明度,他们无法确知人工智能所获得的确切数据。

“透明度变得越来越有限。随着利润被纳入考虑范围,企业的模型更越专有化,更不愿与外界分享,” Pitt Cyber 的政策总监 Jessica Kuntz 表示。这种透明度的缺乏阻碍了针对演算法的监察,令记者很难建立防护措施来遏止偏见的延续。

如果大型科技公司目前这样让 GenAI 无拘无束地发展的情况持续下去,未来充斥人工智能技术的世界将会越来越缺乏多元的观点,例如女性、少数族裔、来自发展中国家或其他文化的观点。

在后续文章中,我将探讨新闻编辑室的两套解决方案,以缓减 GenAI 新闻报道中男性声音的主导地位。

图片来源:Emiliano Vittoriosi on Unsplash.